近日,厦门大学多媒体可信感知与高效计算教育部重点实验室在多媒体领域顶级会议ACM Multimedia2023上录用12篇论文。实验室接收论文简要介绍如下:

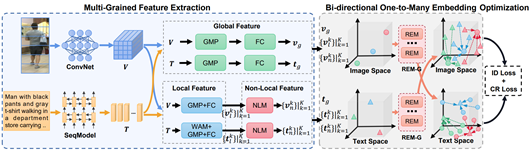

1. Beat: Bi-directional One-to-Many Embedding Alignment for Text-based Person Retrieval

本文为基于文本的行人检索任务提出了一种名为BEAT的双向一对多映射模型,用于解决传统单向映射范式优化不稳定的问题和一对一映射范式忽略图文一对多关系的问题。BEAT首先使用预训练的视觉和文本编码器提取相应的视觉和文本特征,然后使用所提出的残差映射模块组(REM-G)将视觉和文本特征在文本和视觉空间中进行双向一对多的映射。最后,在文本和视觉空间中同时利用损失函数对特征进行优化。实验结果表明,BEAT在CUHK-PEDES、ICFG-PEDES和RSTPReID数据集上均取得了优异的性能,证明了双向一对多映射范式的有效性。

该论文的第一作者是厦门大学信息学院人工智能系2020级硕士生马祎炜,通讯作者是孙晓帅副教授,由纪家沂博士后、江冠南博士(宁德时代)、纪荣嵘教授等共同合作完成。

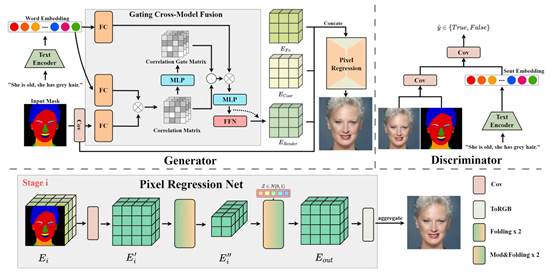

2. PixelFace+: Towards Controllable Face Generation and Manipulation with Text Descriptions and Segmentation Masks

本文提出了一种名为PixelFace+的新型跨模态像素合成网络。通过结合文本描述和分割图,PixelFace+可实现高质量的人脸生成,同时在保留人物面部信息的基础上,支持通过修改输入的文本描述或分割图进行交互式的面部编辑。PixelFace+利用了CLIP的预训练语言编码器来提取输入文本描述的语义信息。基于此,本文提出了门控跨模态注意模块(GCMF),将得到的词嵌入转换为文本先验张量。在视觉信息方面,先通过浅卷积层从输入的分割图中提取视觉先验特征,再将这些文本和视觉先验输入到生成器中以生成最终的面部图像。PixcelFace+在训练过程中使用对抗损失函数,通过学习文本、分割图和生成图像之间的三元组一致性来确保生成的可控性。此外,本文还设计了基于CLIP的正则化损失来对齐视觉语言特征。经过训练,PixelFace+能够通过单个或双重条件输入来实现高度可控的面部生成和操作。为验证PixelFace+的有效性,本文在MultiModal CelebA-HQ数据集上进行了广泛的实验。结果表明,与传统的文本引导人脸生成和编辑方法相比,本文所提出的PixelFace+在图像质量和图文匹配方面具有更好的性能。

该论文共同第一作者是厦门大学信息学院人工智能系2021级硕士生杜晓雄和2019级博士生彭军,通讯作者是孙晓帅副教授,由周奕毅副教授,硕士生张金璐、硕士生陈思亭、江冠南博士(宁德时代),纪荣嵘教授共同合作完成。

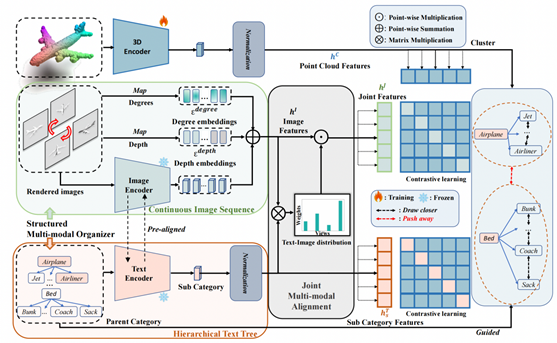

3. Beyond First Impressions: Integrating Joint Multi-modal Cues for Comprehensive 3D Representation

本文横跨3D、文本和图像多个模态,旨在构建3D到自然语言的表征学习与训练框架。近年来,3D表示学习已逐步引入2D视觉-语言预训练模型,以克服数据稀缺的挑战。然而,现有方法仅仅是将2D对齐策略简单地转移到3D表示上,导致了信息退化和协同不足的瓶颈。本文提出了一种名为JM3D的多视角联合模态建模框架,以获得3D点云、文本和图像的统一表示。在数据组织上,本文提出了一种新颖的结构化多模态组织器(SMO),引入了连续随机采样多视角图像和层次化文本以丰富视觉和语言模态的表示,进而解决信息退化问题。同时,本文设计了一种联合多模态对齐(JMA)来解决协同上的不足,并给出了相关的理论推导和原理解释,实现了点云-图片-文本多模态的统一表征。相关代码和数据已在https://github.com/Mr-Neko/JM3D开源。

该论文共同第一作者是厦门大学信息学院人工智能系2021级硕士生王昊为和博士后研究员纪家沂,通讯作者是孙晓帅副教授,由唐霁霁(网易伏羲)、张荣升(网易伏羲)、纪荣嵘教授等合作完成。

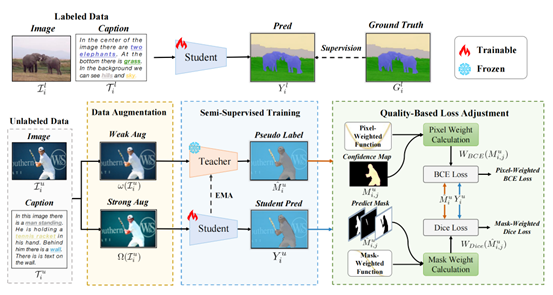

4. Semi-Supervised Panoptic Narrative Grounding

全景叙事定位(PNG)任务需要相对昂贵的像素级标注,这限制了该任务的推广落地。本文提出一个新的任务设定——半监督全景叙事分割(SS-PNG),只需少量的图文对和分割标注,即可完成高效的PNG模型训练,减小了对标注数据的依赖。具体而言,本文采用教师-学生网络架构搭建了SS-PNG-NW网络,探索了Burn-In策略和各种数据增强技术来确定最优设置。针对训练过程中不同样本的伪标签质量存在差异的问题,本文进一步提出了基于伪标签质量的损失函数调整方法,并基于此构建了SS-PNG-NW+网络,以更好地让高质量伪标签指导学生模型学习。基于PNG数据集的各类消融实验验证了所提出方法的有效性。在仅使用30%的标签数据时,所提出的半监督网络甚至可超过全监督模型。

该论文第一作者是厦门大学信息学院人工智能系2022级硕士生杨丹妮,通讯作者是博士后研究员纪家沂博士,由2021级硕士生王昊为、2020级硕士生李毅男、2020级硕士生马祎炜,以及孙晓帅副教授和纪荣嵘教授合作完成。

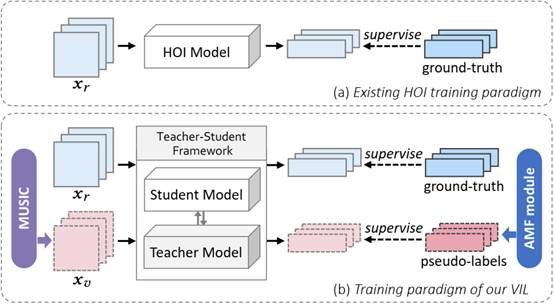

5. Improving Human-Object Interaction Detection via Virtual Image Learning

人-物交互(HOI)检测旨在定位图像中具有交互性的人与物体,并识别两者间的交互关系。HOI的性能受限于严重的长尾问题,为缓解长尾问题,本文提出了模型无关的增益方法——VIL(Virtual Image Learning)。首先,本文设计了名为MUSIC的数据生成法,通过向朴素文本提示添加特定描述生成图像,并采用多环节过滤过程,构造与真实数据集同分布的虚拟数据集。之后,训练时引入教师-学生网络框架。为提升伪标签的质量,本文提出了AMF模块,自适应地对伪标签进行匹配与筛选。最后,本文在HOI常用的两大数据集上与多个现有方法结合,性能的提升证明了本文方法的有效性。

该论文第一作者是厦门大学信息学院人工智能系2020级硕士研究生方姝曼,通讯作者是林贤明助理教授,由2022级硕士研究生刘帅、2019级博士研究生李杰,以及江冠南博士(宁德时代)和纪荣嵘教授合作完成。

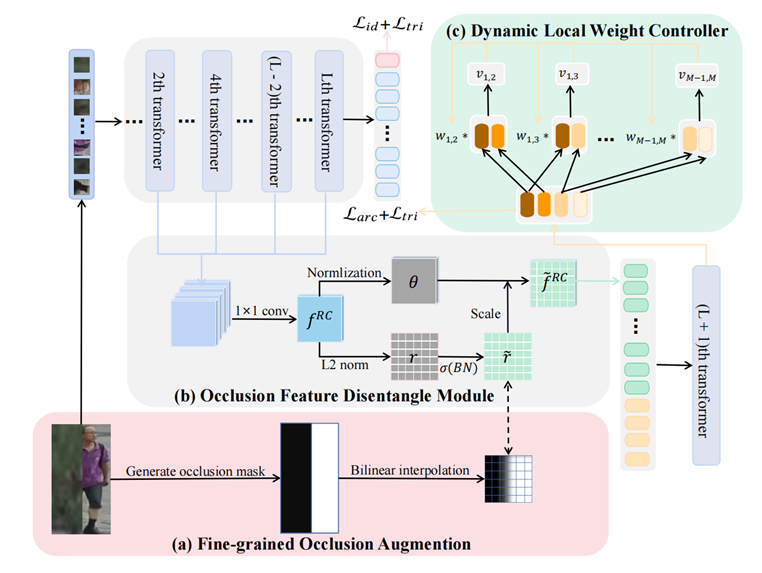

6.Learning Occlusion Disentanglement with Fine-grained Localization for Occluded Person Re-identification

该论文面向行人重识别任务,提出了一个细粒度遮挡解耦网络(Fine-grained Occlusion Disentangled Network,简称为 FODN)。FODN 方法提出了三个组件来改善在遮挡情况下现有方法的不足,分别是精细化遮挡数据增强,遮挡特征解耦模块,动态局部权重控制器。这些组件使得 Transformer 网络能够更精确地去除遮挡的影响,并更好地关注多样性的局部特征。精细化遮挡数据增强方案通过双线性插值产生相应的精细化局部标签,指示行人的哪些具体区域被遮挡。遮挡特征解耦模块,通过解耦范数和角度分别用于遮挡感知和行人重识别任务,缓解了遮挡感知和行人重识别任务的冲突。动态局部权重控制器能够在训练过程中对各个局部token的学习权重进行动态调整,以平衡各个人体部位之间的相对重要性。在该任务的常用公开数据集Occluded-Duke、Occluded-REID等的实验结果充分验证了本文方法的有效性。

该论文第一作者是厦门大学信息学院人工智能系2020级硕士生刘文锋,通讯作者是戴平阳高级工程师,由张岩工程师、纪荣嵘教授、吴永坚(腾讯优图)等共同合作完成。

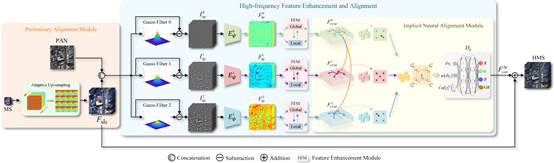

7. Learning High-frequency Feature Enhancement and Alignment for Pan-sharpening

遥感图像全色锐化技术(Pan-sharpening)本质上是利用高分辨率全色图像(PAN)引导低分辨率多光谱图像(LRMS)的超分任务。其主要挑战是如何有效提取PAN图的高频结构和纹理信息,并将其准确注入MS图像。为了解决这个问题,本文提出一个高频特征增强与对齐网络HFEA,网络包括三个模块:基于傅里叶卷积的高频特征增强模块FEM、基于隐式神经表示的高频特征对齐模块INA、以及预对齐模块Pre-align。具体来说,FEM模块使用带注意力机制的快速傅里叶卷积,通过空频双域交互获得全局——局部感受野,以便更有效地抽取不同尺度高频特征。INA模块使用隐式神经表示实现不同尺度高频特征在连续域的精确对齐。Pre-align模块旨在解决PAN图像和MS图像内在不对齐问题。通过在WorldView-II、WorldView-III和 GaoFen2卫星数据集上进行充分实验,验证了本文方法的有效性。

该论文第一作者是厦门大学人工智能研究院2022级博士生王莹莹,通讯作者是丁兴号教授。

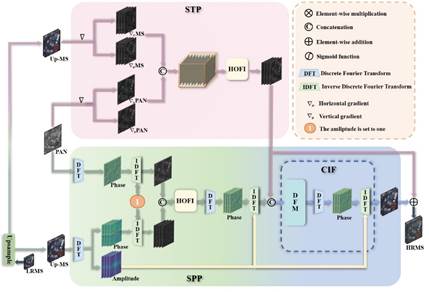

8. Domain-irrelevant Feature Learning for Generalizable Pan-sharpening

现有遥感图像全色锐化技术(Pan-sharpening)假设不同卫星数据服从独立同分布(i.i.d),模型泛化能力不高。本文提出一种可泛化的Pan-sharpening网络——DIRFL。该方法包含两个关键模块:结构保持模块(STP)和光谱保持模块(SPP)。STP在梯度域上融合PAN 和 LRMS高频信息以增强两者的结构一致性。SPP在频域上融合PAN 和 LRMS 的相位特征,进一步提高结构一致性。DIRFL将包含域信息的LRMS 振幅直接注入到不同的融合阶段,在保持模型泛化性能的同时避免光谱信息失真。在WorldView-II、WorldView-III和 GaoFen2三个公共数据集上的测试结果表明,DIRFL不仅能够生成高质量多光谱图像,且具有领先的跨星泛化能力。

该论文的共同第一作者是厦门大学信息学院2023级硕士生林云龙和2019级博士生富振奇,通讯作者是丁兴号教授。

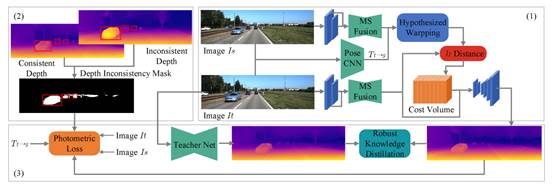

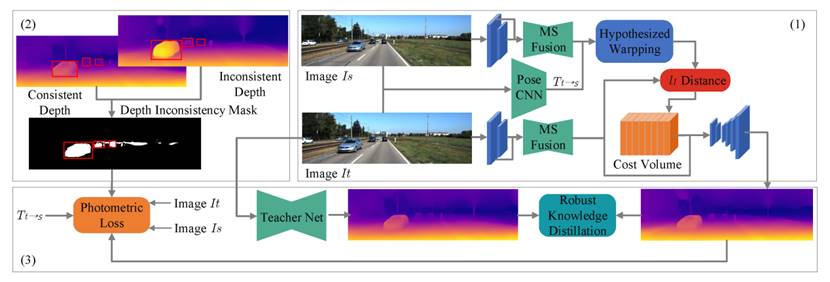

9. Multi-Frame Self-Supervised Depth Estimation with Multi-Scale Feature Fusion in Dynamic Scenes

单目图像自监督深度估计的目标是使用一系列无标签的单目视频帧学习一个深度估计网络。近几年,基于多帧图像的深度估计方法因其利用了额外的时序空间约束,从而在单目深度估计任务中表现出色。针对多帧深度估计方法的局限性,本文首先提出了利用多帧深度估计在动态物体区域的“过拟合”现象与单帧深度估计构建深度一致性掩膜以预测动态区域的方法,并进一步引入单帧教师网络与鲁棒性损失对多帧深度网络在动态区域进行约束。同时,本文引入了多尺度融合模块,用于构建时序空间约束,使得时序空间特征在不同的相机视差具有鲁棒性。本文通过在KITTI和Cityscapes数据集上进行广泛实验,验证了所提出方法在室外场景,尤其是复杂动态场景下的有效性。

该论文第一作者是厦门大学航空航天学院自动化系2022级硕士生钟积权,通讯作者是自动化系喻骁副教授,合作作者为上海交通大学自动化系黄晓霖副教授。

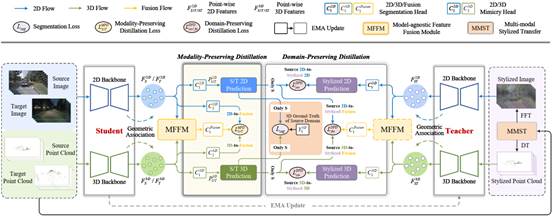

10. Cross-modal Unsupervised Domain Adaptation for 3D Semantic Segmentation via Bidirectional Fusion-then-Distillation

该论文探索了如何利用多模态信息解决3D语义分割的域自适应问题。现有方法忽略了跨模态学习中不平衡的模态适应性问题。为解决上述问题,本文提出了一种基于双向融合再蒸馏的方法,称为BFtD-xMUDA,探索利用多模态融合的互补优势来解决跨模态学习中的负模仿影响,减小了域偏移问题。首先,设计了一个模型无关的特征融合模块(MFFM),从源域和目标域样本中挖掘多模态的外部亲和力,以捕获模态间最相关性特征。其次,基于MFFM,设计了两个互学习机制:即模态保持蒸馏(MPD)和域保持蒸馏(DPD)。MPD通过知识蒸馏使得2D/3D与融合的输出一致,缓解了模态之间的类概率分布差异性。DPD通过知识蒸馏使得源域与风格域的输出一致,缓解了域之间的类概率分布差异性。为了公平有效地验证不同方法在该问题下的表现,本文基于nuScenes: Day→Night,nuScenes: USA→Singapore,以及A2D2→SemanticKITTI三种域自适应场景下进行比较,BFtD-xMUDA取得了2~10%的性能提升。

该论文共同第一作者是厦门大学信息学院计算机科学与技术系2021级博士生吴垚和人工智能研究院2022级硕士生邢明炜,通讯作者是华东师范大学谢源教授和曲延云教授,合作者还有张亚超博士(清华大学),联想公司师忠超研究员和范建平教授等。

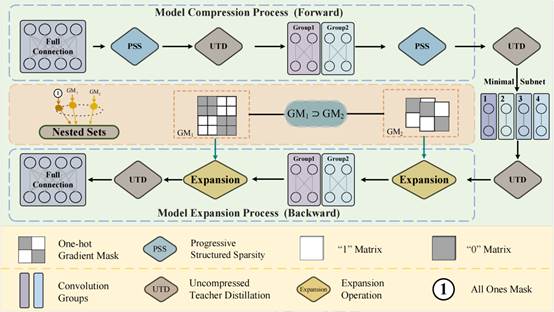

11. Hardware-friendly Scalable Image Super Resolution with Progressively Structured Sparsity

本文提出了一种硬件友好的渐进式结构化稀疏可伸缩超分模型(HSSR),利用分组卷积减少连接权,并通过知识蒸馏保持可伸缩网络中间特征的表示能力,显著缓解了子网的性能下降。HSSR包含两个阶段:渐进模型压缩阶段和渐进模型扩展阶段。首先设计了模型压缩过程(MCP),经过多次迭代,逐步将分组卷积的分组数翻倍,通过知识蒸馏保持小模型的超分性能,最后得到高性能的最小超分模型。在渐进剪枝过程中,每一阶段的参数形成嵌套集,以Tensor形式保存。在模型扩张阶段(MEP),同样经过多次迭代,逐步将分组卷积进行合并,直至恢复至原模型大小。两个阶段都利用了分组卷积底层参数的Tensor结构,并设计了特定形状的二值化梯度掩码,保持子网参数不被改变。实际部署时,可以根据设备资源,提取合适规模子网并快速搭建。所提方法在经典超分模型EDSR、IMDN、IDN进行实例化实验,在主流Benchmark上验证了所提方法的有效性,在压缩90%以上的参数量情况下,性能与原模型可比。

该论文共同第一作者是厦门大学信息学院计算机科学与技术系2021级硕士生叶方晨和2020级硕士生林锦,通讯作者是曲延云教授和华东师范大学谢源教授,合作者还有联想公司师忠超研究员和范建平教授。

12. Multi-Frame Self-Supervised Depth Estimation with Multi-Scale Feature Fusion in Dynamic Scenes

单目图像自监督深度估计的目标是使用一系列无标签的单目视频帧学习一个深度估计网络。近几年,基于多帧图像的深度估计方法因其利用了额外的时序空间约束,从而在单目深度估计任务中表现出色。针对多帧深度估计方法的局限性,本文首先提出了利用多帧深度估计在动态物体区域的“过拟合”现象与单帧深度估计构建深度一致性掩膜以预测动态区域的方法,并进一步引入单帧教师网络与鲁棒性损失对多帧深度网络在动态区域进行约束。同时,本文引入了多尺度融合模块,用于构建时序空间约束,使得时序空间特征在不同的相机视差具有鲁棒性。本文通过在KITTI和Cityscapes数据集上进行广泛实验,验证了所提出方法在室外场景,尤其是复杂动态场景下的有效性。

该论文第一作者是厦门大学航空航天学院自动化系2022级硕士生钟积权,通讯作者是自动化系喻骁副教授,合作作者为上海交通大学自动化系黄晓霖副教授。